Yapay zeka modelleri hayatımızın her alanına entegre olurken, bu teknolojiyi besleyen temel yakıt olan verinin önemi de katlanarak artıyor. Sağlık teşhislerinden kişiselleştirilmiş alışveriş deneyimlerine kadar her yeniliğin arkasında devasa veri setleri yatıyor. Peki, bu durmak bilmeyen inovasyon arayışı içinde en temel haklarımızdan biri olan mahremiyetimizi nasıl koruyacağız? Bu yazıda, yapay zeka çağında veri gizliliğinin karşılaştığı zorlukları ve bu ince çizgide nasıl güvenle yürüyebileceğimizi inceliyoruz.

Veri: Yeni Petrol mü, Yoksa Yeni Sorumluluk mu?

Sıkça duyduğumuz "veri yeni petroldür" benzetmesi, verinin ekonomik değerini vurgulasa da, önemli bir detayı gözden kaçırır: Petrolün aksine, veri kişiseldir, canlıdır ve doğrudan insan hayatına dokunur. Bir yapay zeka modelini eğitmek için kullanılan her bir veri parçası, bir bireyin alışkanlıklarını, tercihlerini, hatta en mahrem bilgilerini içerebilir.

Bu durum, şirketlere ve geliştiricilere sadece teknik bir görev değil, aynı zamanda derin bir etik sorumluluk yükler. Veriyi sadece bir kaynak olarak değil, bireylerin bize emanet ettiği bir değer olarak görmek, sorumlu teknolojinin ilk adımıdır.

"Mahremiyet, saklayacak bir şeyimiz olduğu için değil, korunacak bir benliğimiz olduğu için önemlidir." - Edward Snowden

Yapay Zekanın Gizlilik İkilemleri

Yapay zeka, geleneksel veri işleme yöntemlerinden farklı olarak, veri gizliliği konusunda yeni ve karmaşık zorluklar ortaya çıkarır:

- Yeniden Kimliklendirme (Re-identification): Anonimleştirildiği düşünülen veri setleri, farklı kaynaklardan gelen verilerle birleştirildiğinde, yapay zeka tarafından analiz edilerek kişilerin kimliklerinin yeniden tespit edilmesi riski taşır.

- Algoritmik Önyargı ve Ayrımcılık: Eğer bir model, tarihsel olarak önyargılar içeren bir veri seti ile eğitilirse, bu önyargıları öğrenir ve otomatik kararlarında (örneğin işe alım veya kredi başvurusu) ayrımcılık yapabilir.

- Gözetim ve Takip: Yüz tanıma ve davranış analizi gibi teknolojiler, toplum üzerinde benzeri görülmemiş bir gözetim potansiyeli yaratır ve bu da kişisel özgürlükler için ciddi bir tehdit oluşturabilir.

Çözüm: Güven İnşa Eden Teknolojiler ve İlkeler

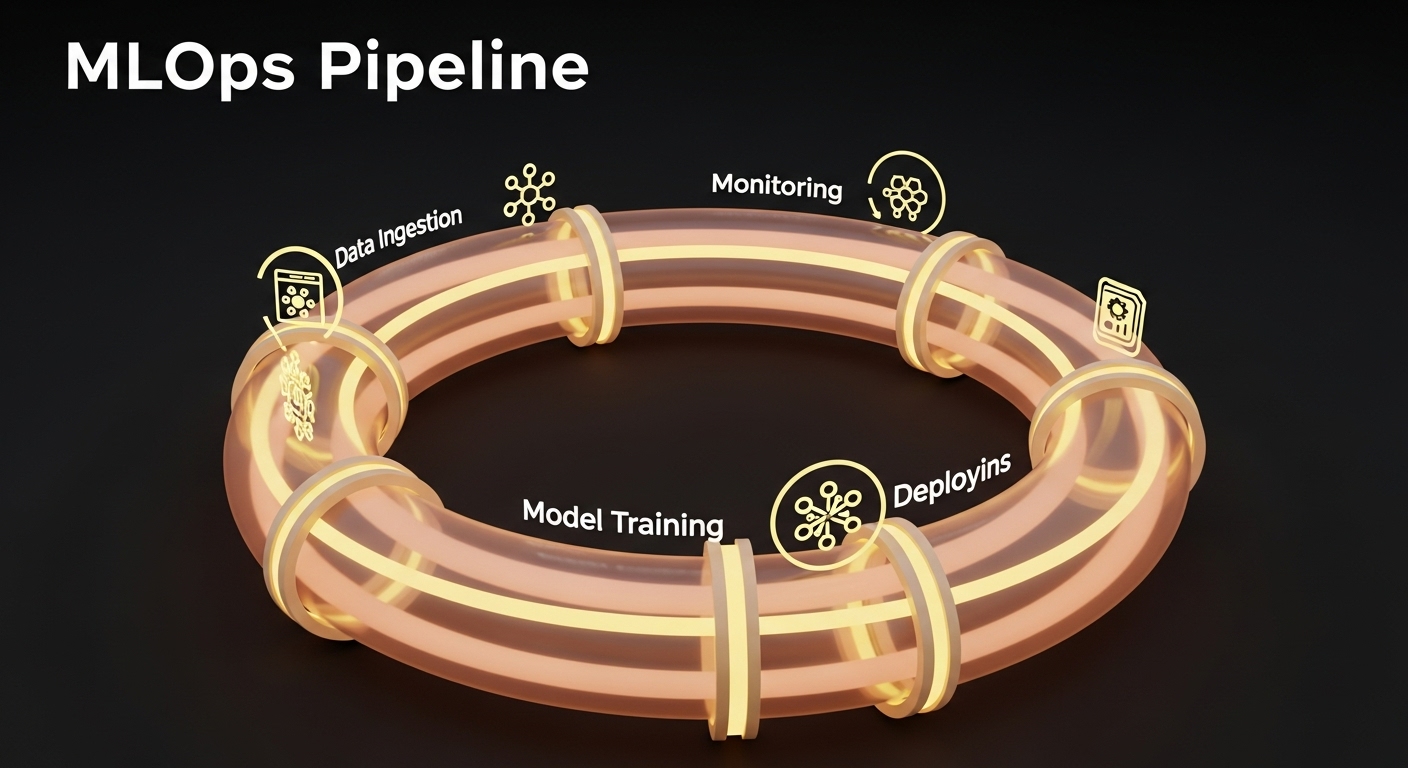

Neyse ki, teknoloji dünyası bu sorunlara yine teknolojinin kendisiyle ve doğru ilkelerle yanıt veriyor. Novahaven olarak biz de bu çözümleri yakından takip ediyor ve projelerimize entegre ediyoruz:

- Federasyon Öğrenme (Federated Learning): Veriyi merkezi bir sunucuya toplamak yerine, yapay zeka modelinin doğrudan kullanıcının cihazında (örneğin telefonunda) eğitilmesini sağlayan bir tekniktir. Bu sayede kişisel veriler cihazdan hiç ayrılmaz.

- Diferansiyel Gizlilik (Differential Privacy): Bir veri setine matematiksel "gürültü" ekleyerek, bireysel kayıtların ayırt edilmesini imkansız hale getirirken, istatistiksel analizlerin doğruluğunu koruyan bir yöntemdir.

- Tasarım Odaklı Gizlilik (Privacy by Design): Gizliliği, bir ürün geliştirildikten sonra eklenecek bir özellik olarak değil, daha en başından tasarım sürecinin temel bir parçası olarak ele alma yaklaşımıdır.